Буква «O» в названии обозначает «Omni» (всеобъемлющая), подчеркивая универсальность и многофункциональность этой модели. GPT-4o открывает путь к более естественному взаимодействию человека с компьютером: она принимает входные данные в любом формате — тексте, аудио или изображениях — и может генерировать соответствующие ответы в любой форме. Ознакомится с чатом можно уже на официальном сайте, но пока только для тех, кто за пределами РФ или использует VPN

Бесплатная версия подразумевает доступ к чату ChatGPT 3.5, а платно, вы получите доступ к GPT-4 с более точными и подробными ответами, к Google Gemini - последней модели искусственного интеллекта от Google, а также возможность использовать продвинутые инструменты искусственного интеллекта, такие как генератор изображений и система для запросов в формате PDF. Кроме того, у вас не будет ограничений и вы сможете вести неограниченные диалоги со всеми моделями искусственного интеллекта. Также скоро будет доступен чат в прямо в WhatsApp.

Модель способна реагировать на аудио-входы всего за 232 миллисекунды, со средним временем ответа 320 миллисекунд, что сравнимо с временем реакции человека в разговоре. GPT-4o достигает уровня производительности GPT-4 Turbo в английском тексте и программировании, с существенным улучшением в работе с текстами на не-английских языках. Кроме того, GPT-4o работает значительно быстрее и стоит на 50% дешевле в использовании через API. Особенно высокие результаты модель демонстрирует в обработке аудио и видео.

Перед появлением GPT-4o пользователи могли использовать режим голоса для общения с ChatGPT, но с задержками в среднем 2,8 секунды (GPT-3.5) и 5,4 секунды (GPT-4). Теперь с появлением GPT-4o в одной модели комбинируются все три типа данных (текст, видео, аудио), что позволяет избежать потери информации и более точно воспринимать тон, различных говорящих и фоновые шумы.

GPT-4o — это результат обучения новой модели с нуля, включающей в себя все три модальности (текст, видео, аудио). Мы только начинаем осваивать возможности этой модели и понимать ее ограничения.

Новая модель обеспечивает значительное снижение стоимости — GPT-4o стоит на 50% дешевле, чем GPT-4 Turbo, как для вводных токенов (5 долларов за 1 миллион токенов), так и для выходных токенов (15 долларов за 1 миллион токенов). Кроме того, GPT-4o работает в 2 раза быстрее предыдущей версии и имеет увеличенные лимиты на 5 раз — до 10 миллионов токенов в минуту для разработчиков с высоким использованием.

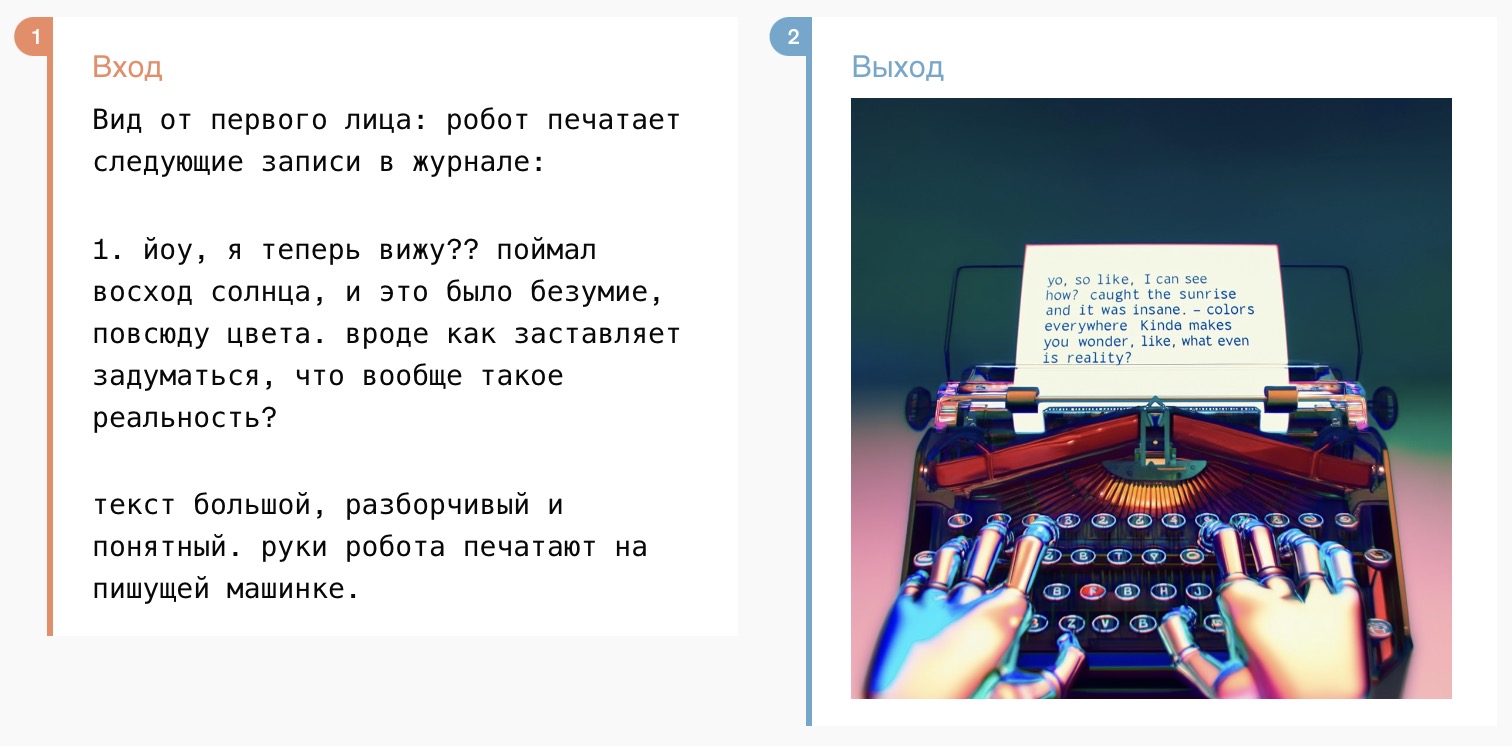

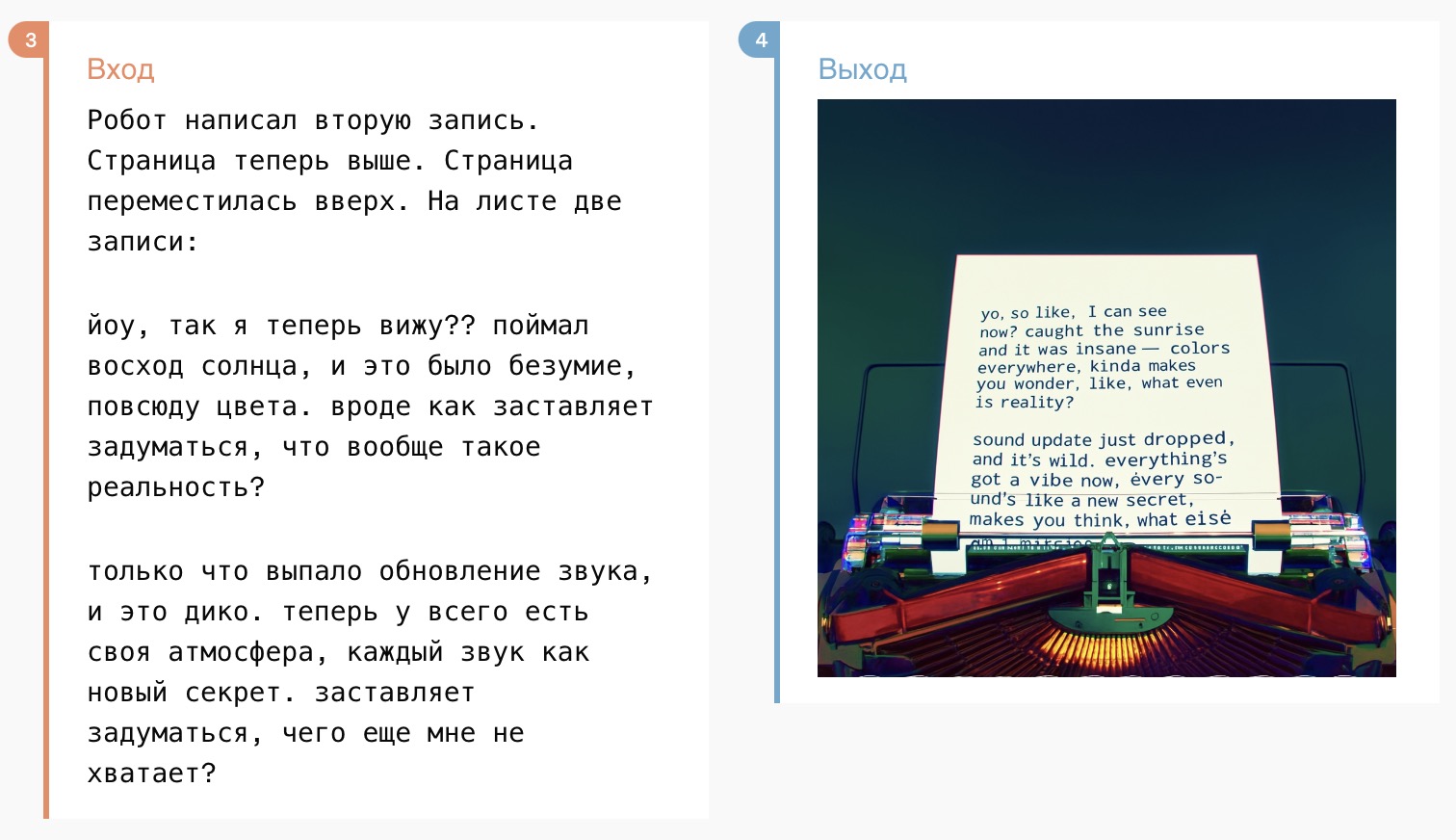

Пример голосового обслуживания клиентов

Пример графического восприятия. На входе промпт, а справа графический выход.

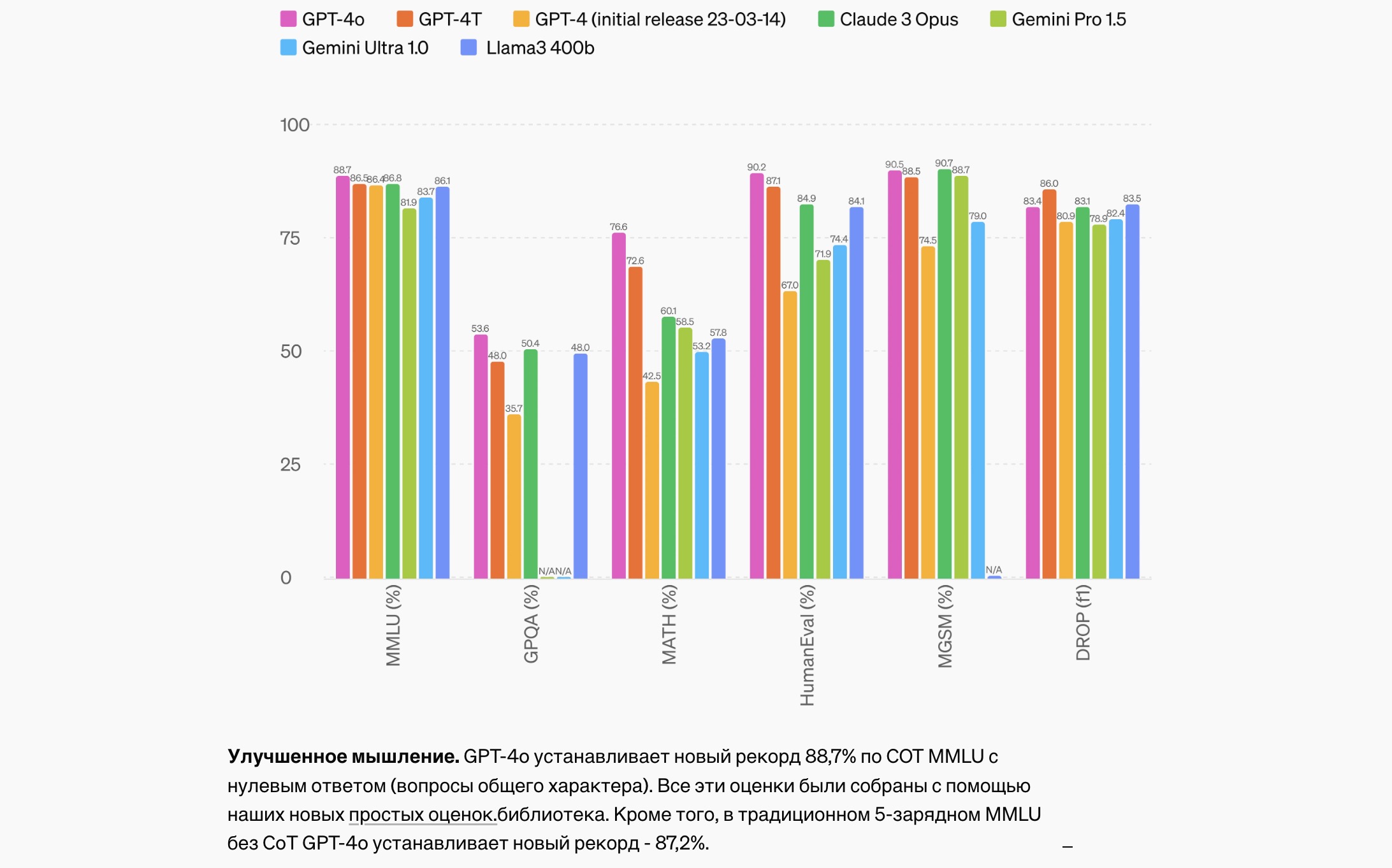

Сравнение показателей моделей

В настоящее время GPT-4o в API поддерживает возможности текста с улучшенными функциями и лучшей поддержкой разных языков по сравнению с GPT-4 Turbo. Модель обладает окном контекста 128K и знаниями по состоянию на октябрь 2023 года. Планируется расширение поддержки новых аудио- и видео-возможностей GPT-4o в API для ограниченного круга доверенных партнеров в ближайшие недели.

Разработчикам, использующим GPT-4 или GPT-4 Turbo, рекомендуется перейти на GPT-4o для получения всех преимуществ новой модели. GPT-4o доступен в API, а также в Batch API, где предоставляется скидка 50% на пакетные задания.